Les modèles de langage ne “pensent” pas mais suivent un processus mathématique précis. Comprendre leur fonctionnement interne permet d’optimiser vos interactions, réduire les coûts et améliorer la qualité des réponses. Du découpage en tokens à la génération finale, voici ce qui se passe réellement.

La mécanique des modèles de langage : des tokens aux réponses

Derrière chaque réponse fluide d’une IA générative se cache une danse mathématique implacable. Loin de la magie noire parfois imaginée, des modèles comme GPT suivent un processus en cinq étaves parfaitement orchestrées qui transforme votre texte d’entrée en réponse cohérente.

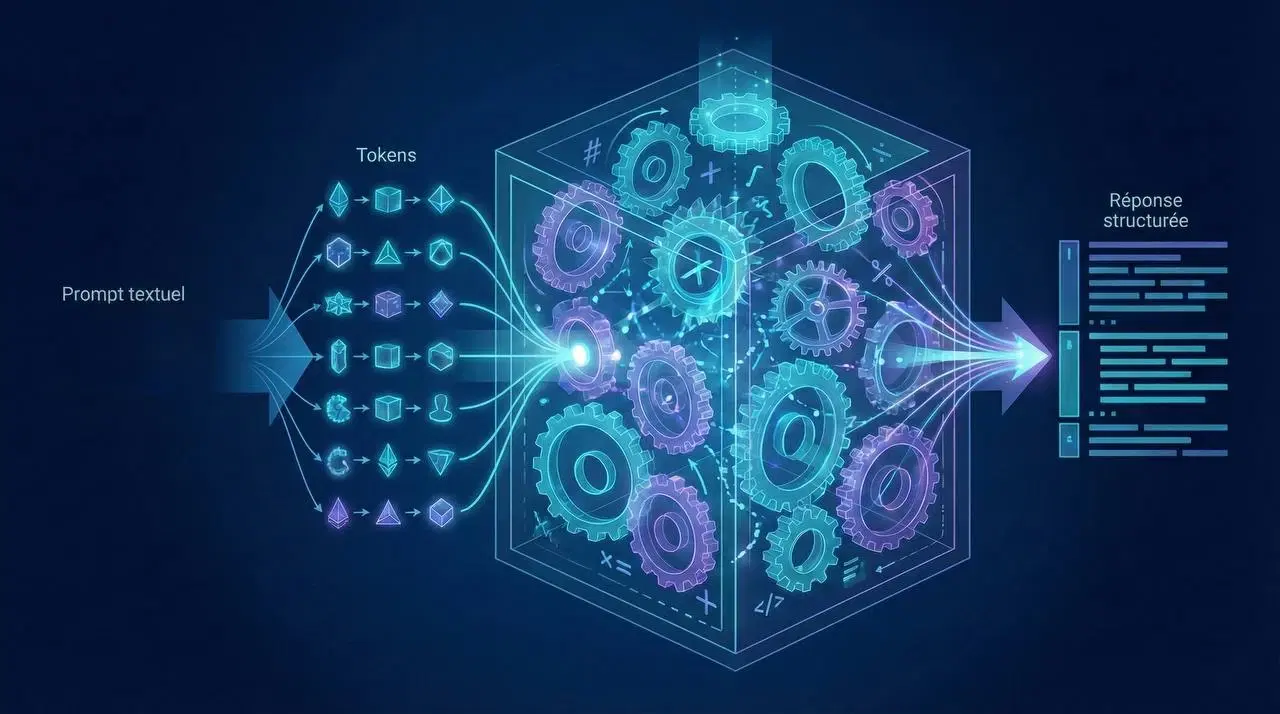

Tokenization : la déconstruction du texte en unités significatives

Avant tout traitement, votre texte subit une opération fondamentale : le découpage en tokens via le Byte Pair Encoding (BPE). Cette étape cruciale réserve souvent des surprises : contrairement à notre intuition, un token ne correspond pas systématiquement à un mot complet. Prenons l’exemple de “Unhappiness” qui devient trois tokens distincts : [“un”, “happi”, “ness”].

Cette tokenisation initiale influence directement l’économie de vos interactions avec l’IA. Les langues non-anglaises génèrent généralement plus de tokens pour un contenu équivalent, chaque unité consommant des ressources computationnelles précieuses. La maîtrise de ce mécanisme constitue le premier pilier de l’optimisation.

Chaque token reçoit ensuite un identifiant numérique transformé en vecteur de 4096 dimensions via une couche d’embedding. Ces vecteurs capturent la sémantique apprise pendant l’entraînement : des mots similaires pointent dans des directions proches dans cet espace multidimensionnel, créant une cartographie sémantique invisible mais essentielle.

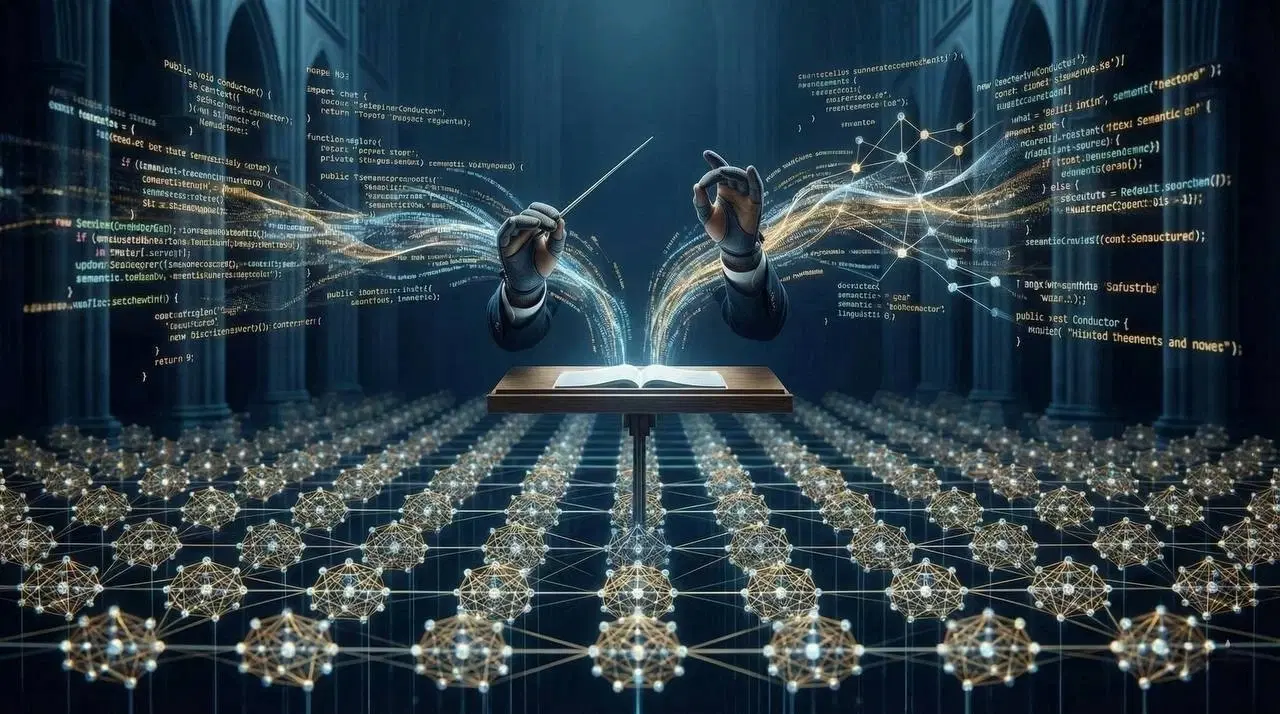

Self-attention : le mécanisme contextuel au cœur des LLM

Le mécanisme d’attention représente le véritable cœur battant des modèles de langage. Pour chaque token, le système calcule trois matrices distinctes : la Query (ce que le token cherche à savoir), la Key (ce qu’il peut offrir) et la Value (l’information réelle qu’il contient).

Ce système sophistiqué détermine l’importance relative de chaque token par rapport à ses voisins via un produit scalaire scaled et une fonction softmax. La multi-head attention exécute ce processus en parallèle avec différentes matrices apprises, permettant de capturer une diversité de relations contextuelles subtiles. Le résultat final n’est pas une “compréhension” au sens humain, mais une représentation mathématiquement enrichie du contexte où chaque token a été recalculé en fonction de son environnement textuel.

Inférence : préremplissage et génération séquentielle

La phase de traitement opère selon une division temporelle cruciale. Le Prefill traite l’intégralité du prompt en parallèle, optimisé pour tirer parti de la puissance de calcul GPU. Vient ensuite le Decode, qui génère les tokens un par un de manière autoregressive.

Cette architecture explique plusieurs phénomènes observables : le premier token arrive rapidement tandis que les suivants sont générés plus lentement, la bande passante mémoire devenant progressivement un facteur limitant. Le KV cache joue ici un rôle essentiel : en évitant de recalculer les matrices Key et Value pour les tokens précédents à chaque nouvelle génération, cette optimisation réduit considérablement les temps de traitement. Sans elle, générer 100 tokens prendrait environ cinq fois plus longtemps.

Alignement et sécurité : la couche éthique finale

La dernière étape du processus consiste en un filtrage via Constitutional AI ou RLHF (Reinforcement Learning from Human Feedback). Cette couche applicative des garde-fous éthiques et comportementaux présente plusieurs caractéristiques : elle ajoute une légère latence, s’avère indispensable pour des déploiements en production et garantit des réponses alignées avec les valeurs humaines.

Guide pratique d'optimisation de vos prompts

Maîtriser les tokens comme une devise précieuse

Chaque token consomme de l’attention computationnelle et représente un coût financier concret. L’optimisation efficace commence par un audit systématique de votre consommation. Utilisez les tokenizers disponibles (comme celui d’OpenAI) pour mesurer votre empreinte réelle. Identifiez les sources de gaspillage : ponctuation excessive, formulations redondantes, structures lourdes. Comparez méthodiquement le coût token entre différentes formulations pour identifier les économies potentielles.

Structuration stratégique pour guider l'attention

L’emplacement des informations dans votre prompt influence considérablement les résultats obtenus. Plusieurs principes doivent guider votre construction : placez le contexte critique en début de prompt pour bénéficier de l’attention mécanique naturellement plus forte dans cette zone. Ancrez le rôle avec des formulations explicites comme “Agis comme un expert en sécurité cloud”. Forcez la pensée étape par étape avec des incitations au raisonnement progressif pour générer des tokens intermédiaires de meilleure qualité.

Techniques avancées validées en production

Plusieurs méthodes ont démontré leur efficacité en conditions réelles. Le Self-prompting consiste à fournir une ébauche de tâche et demander à l’IA d’affiner elle-même le prompt idéal. Cette co-construction réduit les contradictions et améliore la généralisation. La Self-évaluation demande à l’IA de noter sa propre réponse sur une échelle de 1 à 10 avant production. Si le score est insuffisant, elle doit retenter – cette simple astuce améliore significativement la qualité finale. Pour les processus complexes, le découpage des tâches en plusieurs prompts spécialisés (analyse, reformulation, validation) s’avère toujours supérieur.

Pièges et limites à connaître

La mémoire contextuelle : mythes et réalités

Les modèles n’ont aucune mémoire entre les appels hors de la fenêtre contextuelle active. L’augmentation de la taille du contexte ne constitue pas une solution miracle. Le phénomène de “lost-in-the-middle” fait que l’attention se concentre naturellement sur le début et la fin des prompts, négligeant souvent le centre des documents longs. La gestion efficace du contexte long nécessite des stratégies spécifiques de positionnement de l’information critique.

Le Chain-of-Thought (CoT) : une solution contextuelle

Contrairement à certaines croyances, le Chain-of-Thought n’est pas une baguette magique. Son efficacité varie fortement selon les modèles et les tâches spécifiques. Sur les modèles déjà optimisés pour le raisonnement (comme o1 ou Claude Opus), le gain peut s’avérer marginal. Le surcoût reste significatif : entre 20 et 80% en tokens supplémentaires et temps d’exécution.

Checklist d'optimisation en 3 points

Une approche structurée d’optimisation repose sur trois piliers : l’audit tokens via les outils disponibles pour connaître votre consommation réelle et identifier les gaspillages, la structure contextuelle qui place le contexte crucial en tête, les détails au milieu et les instructions précises en fin, et le test itératif qui compare systématiquement les versions avec et sans CoT, avec et sans ancrage de rôle.

L’ingénierie de prompts demeure une discipline empirique où la mesure et l’itération priment. La compréhension mécanique des LLM transforme progressivement l’art du prompt en science reproductible.

En bref

La tokenisation impacte directement les coûts et performances des interactions avec l’IA. L’attention mécanique favorise structurellement le début et la fin des prompts, nécessitant un positionnement stratégique de l’information. Le KV cache optimise la génération mais augmente l’usage mémoire, créant un arbitrage performance/ressources. L’optimisation efficace nécessite une approche structurée, mesurée et itérative.

FAQ

Qu'est-ce que la tokenisation dans les modèles de langage ?

La tokenisation est le processus de découpage du texte en unités significatives (tokens) via le Byte Pair Encoding, où un token ne correspond pas nécessairement à un mot entier.

Comment optimiser ses prompts pour les IA génératives ?

Placez le contexte critique en début de prompt, utilisez l’ancrage de rôle (“Agis comme un expert…”), et structurez la pensée étape par étape pour améliorer la qualité des réponses.

Qu'est-ce que le KV cache et pourquoi est-il important ?

Le KV cache est une optimisation qui évite de recalculer les matrices Key et Value pour les tokens précédents, réduisant significativement le temps de génération mais augmentant l’utilisation mémoire.