Sora, Veo-2 et autres IA vidéo produisent des séquences bluffantes de réalisme. Pourtant, un benchmark inédit de Google DeepMind, Physics-IQ, révèle qu’elles ne comprennent pas la physique qu’elles simulent. Leur succès repose sur l’imitation statistique, non sur l’intelligence causale.

Physics-IQ : le test qui révèle l'incompétence physique des IA

Une équipe de Google DeepMind a conçu Physics-IQ, le premier benchmark systématique évaluant la compréhension physique des modèles de génération vidéo. Cette batterie de tests rigoureux comprend 396 vidéos réparties en 66 scénarios couvrant cinq domaines fondamentaux : mécanique des solides, dynamique des fluides, optique, thermodynamique et magnétisme.

L’exemple le plus parlant est celui d’une chaîne de dominos avec un canard en caoutchouc placé au milieu. Un véritable raisonnement physique impliquerait que seul le segment suivant l’obstacle s’effondre. Les résultats sont sans équivoque : VideoPoet (multiframe), le meilleur modèle testé, n’atteint que 24,1 sur 100, contre une performance humaine de 100 sur 100. Quant à Sora, il affiche environ 20 % en compréhension physique contre 55,6 % en apparence visuelle, confirmant l’absence totale de corrélation entre le réalisme perçu et la compréhension physique réelle.

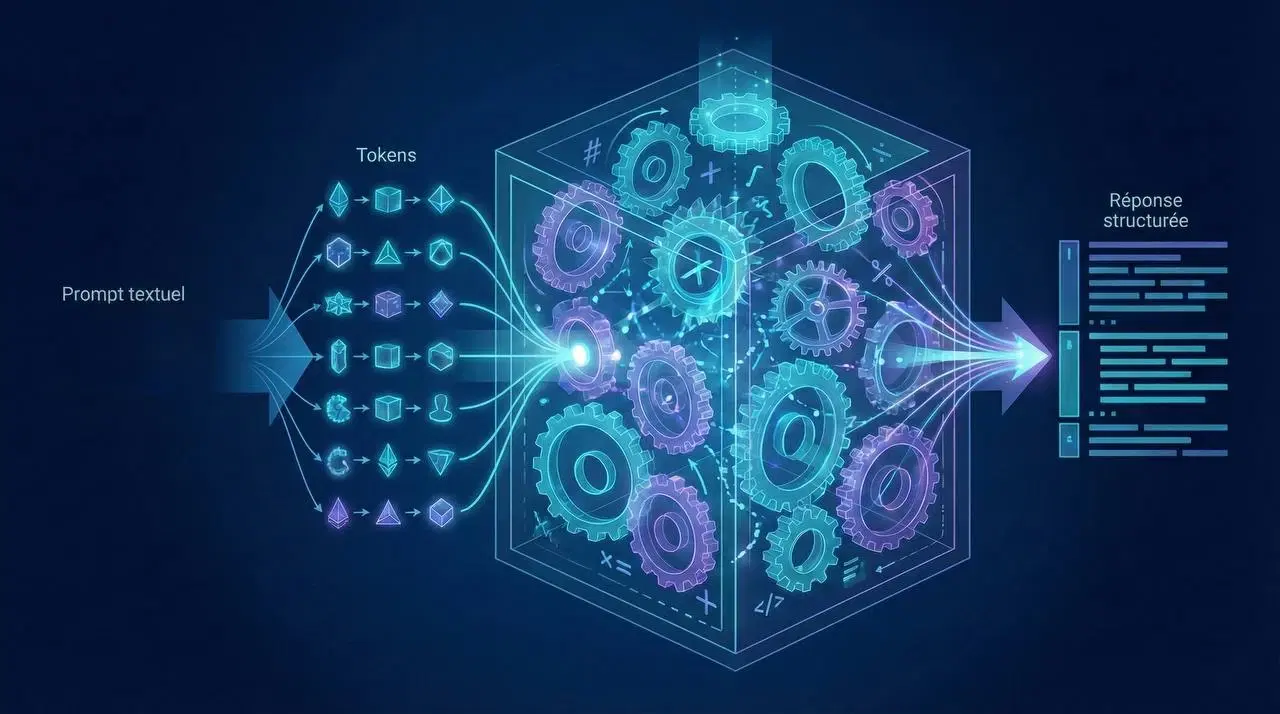

Comment fonctionnent les architectures vidéo actuelles ?

L’évolution technique des modèles vidéo suit une trajectoire impressionnante, mais sans jamais intégrer de véritable raisonnement physique.

Les premières générations, comme VDM (2022), utilisaient des réseaux 3D U-Net qui souffraient d’incohérences temporelles et d’artefacts visuels. La solution émergente fut la reconstruction guidance, une technique permettant de forcer artificiellement la cohérence entre les images successives.

La véritable révolution vint avec le transfert d’apprentissage. Make-a-Video (Meta, 2022) recycla astucieusement des modèles image-texte existants comme Stable Diffusion en ajoutant des couches « Pseudo-3D » pour gérer la dimension temporelle à moindre coût. Stable Video Diffusion (2024) démontra ensuite l’importance cruciale de la curation des données avec 580 millions de paires vidéo soigneusement annotées.

Les modèles les plus récents comme Hunyuan (2024, open-source) introduisent des VAE 3D causaux et des Transformers de Diffusion (DiT), tandis que Sora pousse l’abstraction plus loin avec ses spacetime patches unifiés qui préservent les ratios d’aspect natifs.

Plus de données ≠ meilleure compréhension physique

L’hypothèse dominante selon laquelle l’augmentation des données et des paramètres résoudrait tous les problèmes est formellement contredite par Physics-IQ. La réalité est plus nuancée : davantage de données permet d’apprendre plus de motifs visuels, mais n’apporte aucun gain en compréhension physique fondamentale.La comparaison des modèles récents est éloquente. Veo-2 excelle dans le suivi des instructions, Sora offre un réalisme visuel supérieur, et VideoPoet obtient le meilleur score Physics-IQ avec 24,1/100. Pourtant, aucun ne dépasse un niveau très basique en physique. La scalabilité pure ne comblera pas le fossé entre cognition et illusion.

Optical flow et guidance : les astuces derrière la cohérence

Les mouvements plausibles que nous observons sont souvent le produit de techniques de guidance sophistiquées plutôt que d’une modélisation causale authentique.

Le système MotionPrompt (KAIST, CVPR 2025) illustre parfaitement cette approche. Un discriminateur est entraîné à distinguer les flux optiques réels des flux générés. Pendant la phase de génération, le flux d’un sous-ensemble d’images est calculé, et le discriminateur guide ensuite l’optimisation des tokens. Le résultat ? Des mouvements plus réalistes, certes, mais toujours sans la moindre compréhension de la physique sous-jacente.

Conséquences : création, simulation et régulation

Pour les créateurs et studios, cette limitation signifie que les vidéos générées nécessiteront toujours un contrôle humain rigoureux pour les scénarios physiques complexes. Les incohérences seront particulièrement visibles dans les interactions d’objets, les fluides et les systèmes mécaniques.

Dans le domaine de la robotique et des simulateurs, le danger est réel : il serait catastrophique d’utiliser des vidéos générées comme référence absolue, car les hallucinations physiques biaiseraient profondément les systèmes autonomes.

Pour les régulateurs et les médias, la leçon est claire : il devient crucial de distinguer photoréalisme et vérité physique. Des médias synthétiques peuvent être parfaitement réalistes en apparence tout étant physiquement impossibles, créant un nouveau défi pour la vérification et l’authenticité.

Conclusion : l'intelligence ne se réduit pas à l'apparence

Les IA vidéo contemporaines sont des illusionnistes de génie, maîtresses dans l’art de créer des apparences convaincantes. Mais derrière la magie du spectacle, elles ignorent tout des principes qui régissent l’univers qu’elles simulent. Le benchmark Physics-IQ en apporte la démonstration irréfutable.

Les prochaines avancées significatives nécessiteront probablement une révolution conceptuelle : des architectures intégrant des modèles explicites du monde, l’embodiment par l’interaction avec un environnement réel, et une rupture définitive avec le paradigme du tout-scaling. La route vers une intelligence vidéo véritablement intelligente s’annonce bien plus complexe que prévu, mais aussi bien plus fascinante.

FAQ

Les IA comme Sora comprennent-elles les lois de la physique ?

Non, selon le benchmark Physics-IQ de Google DeepMind, elles excellent en apparence mais échouent sur les principes physiques fondamentaux.

Qu'est-ce que le benchmark Physics-IQ ?

Un test de 396 vidéos évaluant 66 scénarios physiques (mécanique, fluides, optique…), montrant que les modèles vidéo ne dépassent pas 24 % de compréhension.

Quelles techniques utilisent les IA vidéo pour simuler le mouvement ?

Principalement des méthodes de “guidance” comme le flux optique ou la reconstruction guidée, sans maîtriser les causes physiques sous-jacentes.