Derrière les démos spectaculaires, l’IA générative vidéo affiche des limites techniques persistantes : durée courte, artefacts visibles et coûts cachés. Décryptage des vraies contraintes en 2025.

Introduction

C’est le grand paradoxe de l’année 2025 : alors que les démos d’IA vidéo continuent d’éblouir les réseaux sociaux, la réalité du terrain révèle des limitations structurelles qui freinent encore son adoption massive. Entre durée maximale plafonnée à 20 secondes, coûts cachés et artefacts visibles, le chemin vers la production professionnelle reste semé d’embûches.

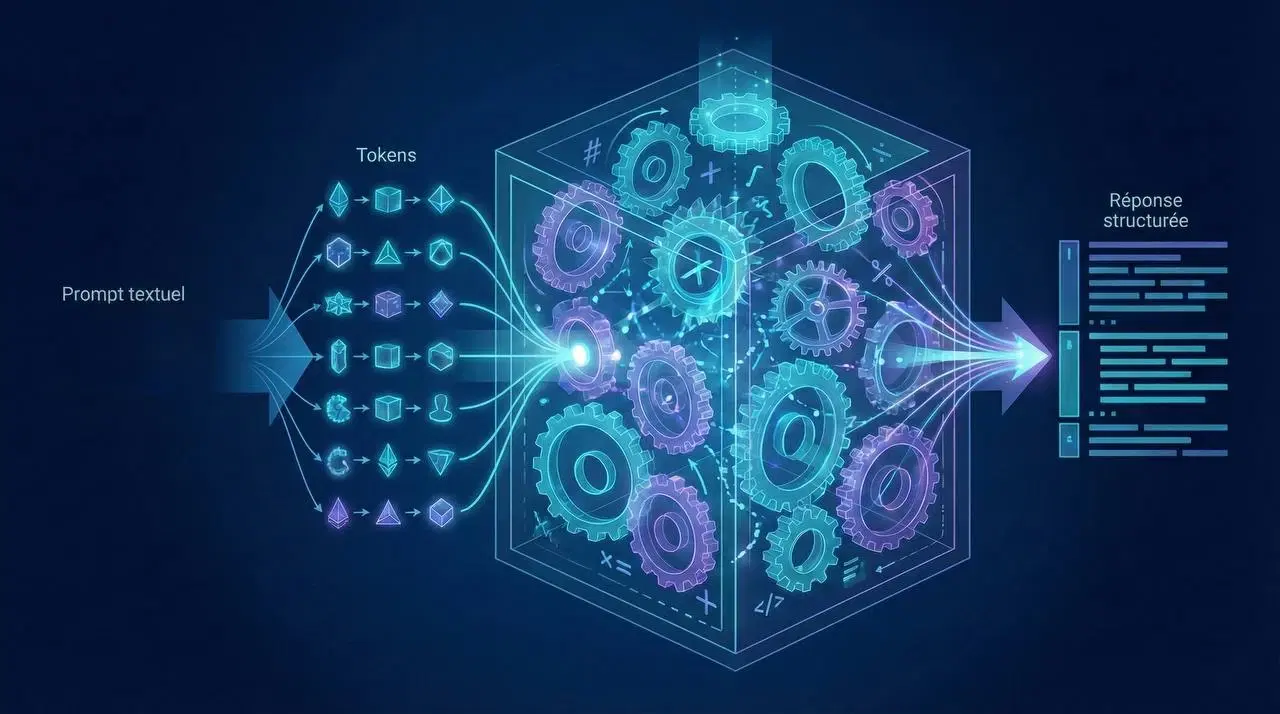

Pourquoi la vidéo est 100 fois plus complexe que l'image

La génération vidéo repose sur un processus de dé-bruitage frame par frame qui soulève des défis uniques. Chaque image débute avec un bruit gaussien indépendant, provoquant des hallucinations différentes sur chaque frame et expliquant le flickering et les incohérences temporelles. Les architectures actuelles peinent à optimiser simultanément la cohérence spatiale (détails au sein d’une frame) et la cohérence temporelle (fluidité entre les frames). Cette difficulté fondamentale se traduit par des artefacts systémiques comme le texture pulsing, l’object morphing ou le semantic drift.

État des lieux technique : durée, coût et qualité en 2025

Le panorama des solutions d’IA vidéo actuelles révèle des contraintes matérielles et économiques significatives. Les modèles leaders comme Sora 2 peinent à dépasser les 20-22 secondes en 1080p-4K pour un coût mensuel oscillant entre 20 et 200 dollars. Runway Gen-4 se limite à 16 secondes en 4K pour 12-95 dollars, tandis que Pika 2.5 n’excède pas 8-10 secondes en 1080p. Seul Veo 3 promet jusqu’à 60 secondes, mais au prix prohibitif d’environ 30 dollars par minute.

L’infrastructure cloud ou locale impose des contraintes physiques incontournables : le coût compute varie entre 0,06 et 0,16 dollar pour 10 secondes, et doubler la durée signifie doubler les besoins en VRAM. Ces limitations techniques se répercutent directement sur la viabilité économique des projets.

Les artefacts visuels : où l'IA échoue encore

Trois problèmes majeurs persistent et trahissent l’immaturité des modèles. Le flickering se manifeste par des variations brutales de texture, couleur ou position causées par l’inconsistance du bruit entre les frames. Les techniques de temporal regularization n’apportent que 5 à 10 % d’amélioration.

L’object morphing voit les objets changer de forme ou se dissoudre après 4 à 6 secondes, révélant l’incapacité des modèles à maintenir une représentation stable. Enfin, le semantic drift entraîne une perte de la synchronisation labiale et des incohérences des expressions faciales au-delà de 10 secondes, comme si le modèle « oubliait » le contexte narratif initial.

Manque de contrôle éditorial et granularité

Le processus créatif souffre d’un manque crucial de granularité. Seul Runway propose un vrai post-editing avec son Motion Brush et son temporal re-prompting. Les autres outils fonctionnent en mode « shoot once, pray it’s right », obligeant à une régénération totale à chaque tentative sans itération incrémentale. Cette approche génère un coût complet à chaque essai, rendant le processus peu adapté aux workflows professionnels exigeant précision et révisions.

Viabilité économique : où l'IA vidéo s'impose (et où elle échoue)

L’analyse économique révèle une adoption très contextuelle. Pour la publicité TV 30 secondes, où les coûts traditionnels varient entre 15 000 et 100 000 dollars, l’IA propose une alternative à 300-1000 dollars avec une adéquation moyenne. Dans le jeu vidéo et les VFX, son utilité reste faible face aux coûts et exigences techniques. En revanche, pour les contenus réseaux sociaux où les budgets sont naturellement plus faibles, l’IA présente une adéquation élevée avec des coûts mensuels de 8 à 95 dollars.

L’IA est déjà compétitive pour les formats courts et les prévisualisations, mais reste inadaptée pour les productions premium, narratives longues ou nécessitant une précision physique parfaite.

Solutions émergentes : entre progrès réels et limitations structurelles

Plusieurs approches tentent de contourner les obstacles techniques. FramePack permet une génération locale avec seulement 6 Go de VRAM, mais au prix d’une qualité réduite. HunyuanVideo-1.5 réduit les besoins matériels (8 Go au lieu de 40), mais dégrade la qualité sur les séquences longues. Les recherches sur le long-forme (LongCat, LTX-2) restent largement théoriques et peu validées.

Si les techniques de temporal regularization progressent, elles ne résolvent pas le problème fondamental : l’indépendance du bruit entre les frames qui mine la cohérence temporelle.

Roadmap 2026 : ce qu'on peut vraiment attendre

Les 6 à 12 prochains mois devraient permettre des avancées significatives avec une durée étendue à 30-60 secondes et une qualité qui atteindra un plateau acceptable. Mais les barrières restent physiques et économiques : le scaling VRAM demeure problématique et le coût compute devient prohibitif pour les longues durées.

L’IA vidéo ne remplacera pas encore le live-action pour les narratives longues, les applications médicales ou scientifiques, et les productions audiovisuelles haut de gamme. La révolution promisesera progressive plutôt que disruptive.

En bref

- L’IA vidéo perce sur les formats courts et réseaux sociaux

- Les artefacts (flickering, morphing, semantic drift) persistent

- Le contrôle créatif reste limité

- La viabilité économique est réelle… mais contextuelle

FAQ

Quelle est la durée maximale d'une vidéo générée par IA en 2025 ?

Elle dépasse rarement 20 secondes pour la majorité des modèles, avec des exceptions comme Veo 3 pouvant aller jusqu’à 60 secondes.

Quels sont les artefacts visuels les plus courants ?

Le flickering, l’object morphing et le semantic drift sont fréquents et trahissent l’immaturité des modèles.

L'IA vidéo est-elle économiquement viable pour une production professionnelle ?

Oui pour les contenus courts et réseaux sociaux, mais pas encore pour les productions haut de gamme ou narratives longues.

Sources

- https://arxiv.org/html/2502.17863v1

- https://medium.com/@nandinilreddy/why-ai-videos-look-fake-and-how-physics-can-fix-it-bb84149831d8

- https://www.upuply.com/blog/what-are-the-limitations-of-current-ai-video-generation-models

- https://skywork.ai/blog/sora-2-vs-veo-3-vs-runway-gen-3-2025-ai-video-generator-comparison/

- https://www.tomshardware.com/tech-industry/artificial-intelligence/framepack-can-generate-ai-videos-locally-with-just-6gb-of-vram

- https://max-productive.ai/ai-tools/runwayml/

- https://arxiv.org/html/2503.15417v1

- https://www.xugj520.cn/en/archives/hunyuanvideo-1-point-5-lightweight-ai-video-generation.html