L’IA scientifique révèle désormais l’inattendu : lois physiques inédites, traces de photosynthèse vieilles de 3,3 milliards d’années, mécanismes du cholestérol. Ces découvertes émergent sans avoir été programmées. Comment l’intelligence artificielle, pourtant déterministe, produit-elle de la sérendipité ? Éclairage sur un paradoxe qui redefine la recherche.

Quand l'algorithme voit plus loin que la théorie

Des physiciens découvrent des lois inédites dans les plasmas poussiéreux. Des biologistes détectent les plus anciennes traces de photosynthèse en analysant des roches vieilles de 3,3 milliards d’années. AlphaFold révèle comment le cholestérol obstrue les artères. Aucune de ces avancées ne figurait dans les objectifs initiaux des chercheurs ou les fonctions de coût des modèles. Elles sont le fruit d’un phénomène fascinant : la sérendipité algorithmique, cette capacité de l’IA à produire l’imprévu.

C’est là le paradoxe : un système conçu pour optimiser des paramètres engendre des découvertes qui n’étaient pas sa cible. Comment un processus aussi mécanique qu’une itération mathématique peut-il générer de la surprise scientifique ?

Des lois physiques oubliées refont surface à Emory

À l’université Emory, des physiciens ont osé une expérience audacieuse. Ils ont entraîné un réseau de neurones sur des trajectoires de particules dans un plasma poussiéreux, une configuration complexe où les forces entre particules se manifestent de façon chaotique. Le système a identifié deux anomalies majeures qui contredisaient l’intuition établie.

D’abord, les forces entre particules ne sont pas réciproques. Ensuite, la charge des particules dépend non seulement de leur rayon, mais aussi de la densité et de la température du plasma. Tercio, la décroissance des forces varie avec la taille des particules selon un motif inattendu.

Le modèle affichait une précision supérieure à 99%, et ce qui le rendait révolutionnaire, c’était que ses décisions restaient interprétables. Il respectait les symétries physiques fondamentales. Cela transformait une prédiction statistique en compréhension véritable, transférable à d’autres systèmes complexes. Les chercheurs ne l’avaient pas programmé pour cela ; l’IA l’avait extrait des données elles-mêmes.

Des roches qui parlent : la photosynthèse remonte le temps

L’équipe de Carnegie Science a conçu une stratégie différente. Elle a déployé un modèle de machine learning sur 400 échantillons de roches, des spécimens géologiques analysés des dizaines de fois par les chercheurs humains. L’IA accomplissait une tâche singulière : identifier les traces biogéniques, ces marqueurs chimiques laissés par la vie ancienne.

Les résultats ont stupéfié. L’algorithme a découvert des signatures de photosynthèse dans le Josefsdal Chert datant de 3,3 milliards d’années, repoussant ainsi les origines connues de ce processus fondamental. Il a également détecté des traces dans la Gamohaan Formation remontant à 2,5 milliards d’années. Comment était-ce possible ? Parce que l’IA analysait des dizaines de milliers de pics chimiques par échantillon, contre quelques centaines pour un géochimiste même expérimenté.

Le système fonctionnait comme une reconnaissance faciale, mais de fragments moléculaires. Et voici le plus troublant : il a découvert des algues sur des coquilles mortes que les chercheurs avaient initialement écartées comme des erreurs de manipulation. Ces “faux positifs” n’étaient pas des faux du tout. Ils révélaient une réalité que l’expertise humaine avait voilée par ses propres cadres d’analyse.

Le moteur caché : reconnaissance de motifs multidimensionnels

Pourquoi l’IA produit-elle de l’inattendu ? Parce qu’elle excelle dans un domaine où les humains achoppent : naviguer les espaces de données multidimensionnels sans préjugé théorique. Contrairement aux chercheurs guidés par des hypothèses, l’IA n’a pas de parti pris. Elle n’a jamais entendu parler des théories en vigueur ; elle apprend les espaces latents qui capturent les corrélations implicites, celles qui restent invisibles à l’oeil nu.

Elle reconnaît des structures analogues même dans des contextes différents, établissant des connexions que la science fragmentée en disciplinaires n’aurait jamais songer à explorer. Mais il ne faut pas surestimer ce qu’elle fait : elle n’invente rien. Elle extrait des données ce que la théorie ne voyait pas, un geste crucial mais modeste.

L’interprétabilité devient alors cruciale. Un modèle compréhensible transforme une surprise algorithmique en découverte scientifique valide. C’est la différence entre une anomalie numérique et une avancée authentic.

Le génie des erreurs utiles

Ici surgit un phénomène contre-intuitif : certaines “erreurs” de l’IA se révèlent être des découvertes mal contextualisées. Prenez cette coquille morte que l’algorithme flaggue comme photosynthétique. Première réaction : la machine s’est trompée. Seconde réaction, celle d’un chercheur attentif : pourquoi ? Réponse : elle était couverte d’algues. Ou ce nid de guêpe associé à la photosynthèse, une confusion apparente qui cache un fait réel : le bois utilisé contenait des traces organiques pertinentes.

Ces faux positifs générateurs de savoir forcent les chercheurs à reconsidérer leurs hypothèses. Ils ne sont pas des distractions mais des portes ouvertes sur des phénomènes inattendus. Le vrai défi est de cultiver ces erreurs utiles sans être submergé par le bruit massif.

AlphaFold : les découvertes collattérales du géant

AlphaFold 2 incarne le cas d’école. Conçue pour prédire des structures protéiques avec une fiabilité inédite, cette IA a engendré des cascades de découvertes imprévues.

Prenez le cholestérol LDL, cet assassin silencieux responsable des maladies cardiovasculaires. AlphaFold a résolu en quelques minutes la structure tridimensionnelle complète de l’apolipoprotein B100, une protéine géante de 4536 acides aminés que les techniques expérimentales classiques peinaient à cartographier après des décennies d’efforts. Cette révélation a immédiatement orienté le développement de nouveaux traitements cardiovasculaires.

Ou pensez aux abeilles. Des chercheurs ont puisé dans AlphaFold pour comprendre la Vitellogenin, une protéine cruciale pour l’immunité de ces insectes pollinisateurs essentiels. Résultat : des élevages utilisant cette connaissance pour produire des colonies plus résilientes, sans détour par les produits chimiques.

Les chiffres attestent l’ampleur : 3 millions de chercheurs utilisent la base AlphaFold, plus de 35 000 articles scientifiques citent l’outil, et 40% des structures nouvelles soumises à la communauté proviennent d’utilisateurs qui ont exploité le modèle bien au-delà de sa fonction première. Dans la recherche clinique, les citations ont doublé. Aucune de ces applications n’avait été anticipée lors de la conception du modèle.

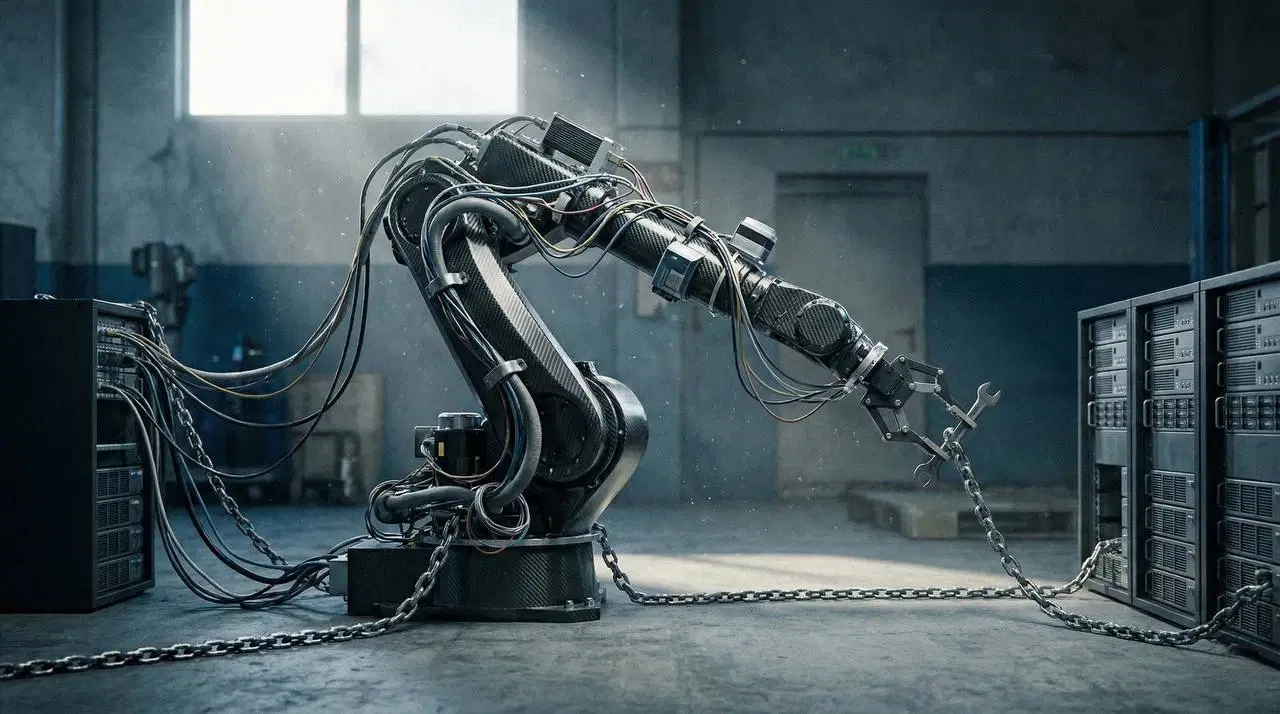

Le mur de la réalité : 2,2 millions de cristaux fantômes

Mais la sérendipité n’excuse pas la recklessness. En 2022, DeepMind annonçait fièrement la découverte de 2,2 millions de structures cristallines stables, des matériaux potentiels pouvant révolutionner la technologie. L’euphorie retomba vite. Une analyse indépendante menée en 2025 rendit son verdict : “mostly junk”.

Les structures étaient chimiquement impossibles ou dénuées d’intérêt pratique. Zéro nouveau matériau utilisable n’en a émergé. Le modèle avait généralisé bien au-delà de ce que les données physiques autorisaient. C’est l’envers de la sérendipité : l’hallucination algorithmique, la confabulation statistique présentée comme découverte.

Cet échec cristallin rappelle une vérité incontournable : la validation expérimentale reste indispensable. Les approches physics-guided, comme celle déployée à Emory, surpassent les modèles purement data-driven précisément parce qu’elles respectent les contraintes physiques fondamentales. Elles contraignent l’imagination algorithmique dans les limites du réel.

Opérationnaliser l'imprévu : SciLink et l'exploration intentionnelle

La communauté scientifique ne se contente plus de profiter de la sérendipité par chance. Elle la cultive systématiquement. En août 2025, émergeait SciLink, un framework conçu pour organiser la découverte imprévisible.

Le système fonctionne selon quatre étapes imbriquées. D’abord, l’acquisition automatisée par robotique, qui élimine les biais de sélection humaine. Ensuite, l’analyse contextuelle multi-domaines, qui reconnecte les découvertes isolées dans une cartographie scientifique plus large. Puis, l’exploration d’espaces multi-objectifs, permettant aux chercheurs d’interroger non pas “quel est l’optimum pour X ?” mais “où l’espace des possibles se déploie-t-il ?” Enfin, la boucle théorie-in-the-loop, qui signale les divergences entre théorie et données, ces fissures où gît l’inattendu.

L’objectif n’est plus d’optimiser pour une variable prédéfinie. C’est d’explorer systématiquement où la théorie échoue, transformant l’erreur en catalyseur de découverte.

La réhabilitation du chercheur expert

Contre l’illusion du remplacement technologique, la réalité est bien différente : un partenariat renforcé, rendu plus exigeant. L’IA trouve des corrélations, souvent bruyantes, souvent fragmentaires. Le chercheur expert devient le validateur et l’interprète indispensable. Il pose les bonnes questions, il conteste l’IA quand elle hallucine, il recontextualise ses trouvailles dans l’écosystème scientifique existant.

Son rôle s’élève plutôt qu’il ne s’érode. Comprendre pourquoi l’IA s’est “trompée utilement”, ou comment elle a extrait un signal que la théorie cachait, demande une expertise accrue. Les domaines bénéficieront d’une accélération radicale : ceux où la validation expérimentale est rapide et accessible. Les autres, comme l’astronomie ou la géologie, deviendront plus efficaces en réduisant les impasses théoriques, mais sans révolution immédiate.

Vivre avec l'imprévisibilité productive

Le paradoxe de la sérendipité algorithmique n’est pas un bug mais une feature de l’IA scientifique. En 2025, elle a révélé des mécanismes biologiques fondamentaux oubliés, étendu notre compréhension des forces physiques, fait parler des roches vieilles de milliards d’années. La promesse n’est pas une IA magique mais un partenariat radical : l’expertise humaine, armée de questions pertinentes, combinée à la patience et l’absence de biais de l’algorithme.

Le défi du siècle scientifique sera de distinguer le signal du bruit massif, une tâche incomparablement plus difficile mais incomparablement plus riche. Nous apprenons à vivre avec une intelligence qui nous surprend parce qu’elle pense différemment de nous. C’est peut-être le début d’une collaboration authentique.

FAQ

Comment l'IA peut-elle faire des découvertes scientifiques inattendues ?

En reconnaissant des motifs cachés dans les données que les théories existantes ou les préjugés humains occultent.

Les découvertes de l'IA sont-elles toujours fiables ?

Non, elles doivent être validées expérimentalement. Certaines approches comme les modèles “physics-guided” réduisent les risques d’erreur.

Quel est le rôle du chercheur face à l'IA ?

Il valide, contextualise et interprète les résultats de l’IA, transformant des corrélations statistiques en véritables découvertes.

Sources

- https://news.emory.edu/features/2025/07/esc_ai_dusty_plasma_30-07-2025/index.html

- https://www.scientificamerican.com/article/ai-uncovers-oldest-ever-molecular-evidence-of-photosynthesis/

- https://deepmind.google/blog/alphafold-five-years-of-impact/

- https://arxiv.org/abs/2508.06569

- https://www.nature.com/articles/d41586-025-00228-7

- https://www.technologyreview.com/2025/12/15/1129210/ai-materials-science-discovery-startups-investment/