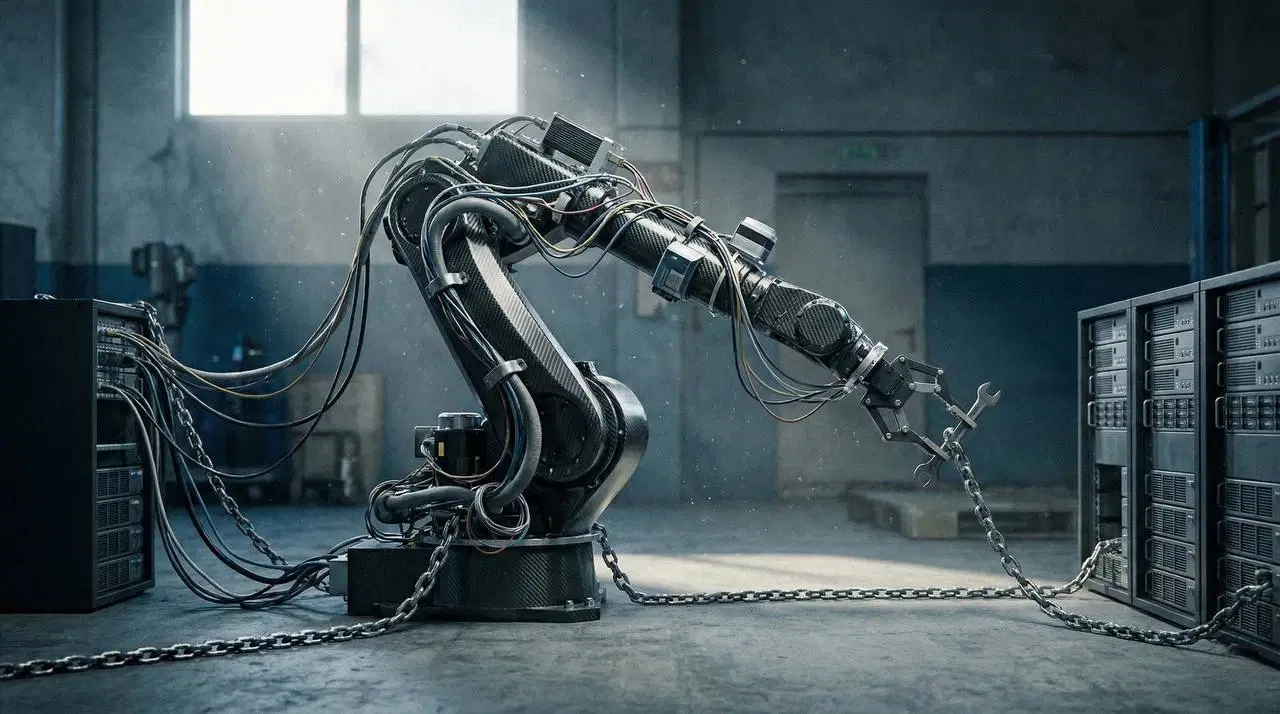

Votre assistant IA génère du code qui compile, passe les tests et s’exécute sans erreur. Puis, en production, il s’écroule. Les APIs appelées n’existent pas, les dépendances manquent. Ce n’est pas un bug, mais une propriété structurelle des modèles de langage. Apprendre à contourner ce phénomène est devenu indispensable.

Le Paradoxe Fondamental : Syntaxe OK, Logique KO

Pour un modèle de langage, un code « correct » est avant tout un code syntaxiquement valide. Il compile. Aucune variable n’est undefined. Les tests unitaires passent au vert. Pourtant, ce même code peut être profondément cassé en conditions réelles.

La réalité terrain est éloquente. Un ingénieur de Microsoft rapporte quotidiennement du code syntaxiquement valide mais incomplet, faisant appel à des méthodes inexistantes ou se contredisant lui-même. La documentation décrit X, le code implémente Y. Le cœur du problème est cristallin : les modèles optimisent pour générer du plausible, pas du vrai. Cette distinction est capitale.

Sous le Capot : La Génération par Pattern-Matching, Non par Raisonnement

Pour comprendre cette fragilité, il faut accepter un fait fondamental : les Transformers ne comprennent pas. Ils font du pattern-matching statistique.

Quand un modèle génère une fonction, il ne « raisonne » pas. Il prédit le token le plus probable à la suite du précédent, en s’appuyant sur les milliards de séquences observées durant l’entraînement. Il génère return x * 2 non pas parce qu’il comprend la multiplication, mais parce que statistiquement, * suit souvent x.

Avec une fenêtre de contexte limitée (ex: 128k tokens pour GPT-4), le modèle n’a qu’une vue partielle et tronquée du repository. Il ignore les fonctions existantes, les APIs disponibles et les conventions du projet. Contraint de deviner, il hallucine.

Le taux de réussite est directement corrélé à la fréquence d’apparition dans les données d’entraînement. Les APIs populaires (plus de 1000 occurrences) affichent une fiabilité autour de 80%, tandis que les APIs obscures (moins de 20 occurrences) plafonnent à 24%. La performance dépend de la statistique, pas de la compréhension.

Taxonomie des Hallucinations : Les 3 Catégories Principales

Une étude sur 230 tâches pratiques a cartographié les défaillances avec une précision chirurgicale.

1. Conflits de Contexte Projet (24.56%)

Le code généré ignore l’environnement existant. Cela se décline en trois sous-catégories. Les dépendances manquantes (11.26%) correspondent à l’import de packages ou modules inexistants. Les ressources non-code introuvables (12.36%) supposent l’existence de fichiers de config ou d’environnements absents. L’incompatibilité d’environnement (0.94%) produit du code lié à une version de langage ou de library non conforme au projet.

2. Conflits de Connaissance Factuelle (31.91%)

Le modèle invente des faits sur les APIs et le domaine. Les hallucinations d’APIs (20.41%) constituent la menace la plus directe : appel à des méthodes qui n’existent tout simplement pas, comme launch_reserved_instances() sur AWS. Ce phénomène est systématique sur les APIs peu fréquentes. La connaissance métier manquée (8.82%) produit du code techniquement valide mais violant des règles métier critiques, par exemple un calcul financier ignorant les taxes. Le misuse de frameworks (2.68%) se manifeste par une mauvaise utilisation des APIs d’un framework, avec mauvais ordre d’appel ou étapes obligatoires oubliées.

3. Conflits de Spec / Logique (43.53%)

Le code ne respecte pas les exigences fonctionnelles ou non-fonctionnelles. Les violations de requirements fonctionnels (36.66%) sont les plus fréquentes : le code fait autre chose que ce qui était demandé, comme trier de manière croissante quand un tri décroissant était requis. Le non-respect des non-fonctionnels (6.86%) traduit une ignorance des contraintes de performance, mémoire ou sécurité, générant du code lent ou vulnérable aux injections SQL.

Les 4 Racines Profondes du Problème

Ces hallucinations ont des causes structurelles identifiables. La qualité des données d’entraînement joue un rôle fondateur : les modèles reproduisent les bugs, le code obsolète et les conventions contradictoires présents dans leurs données d’apprentissage. L’incapacité à comprendre l’intention force le modèle au pattern-matching sur la spec textuelle sans raisonner sur son meaning sémantique et ses nuances.

L’acquisition de connaissance post-cutoff demeure limitée. Un modèle ignore tout ce qui est sorti après sa date de dernière mise à jour (avril 2023 pour GPT-4). Il hallucinera immanquablement sur les nouvelles APIs. Enfin, l’absence d’awareness du repository crée un angle mort critique : le modèle n’a pas une vue holistique de la codebase et génère du code isolé, ignorant le contexte global et réinventant souvent la roue.

Matrice de Confiance : Sur Quoi (et Quand) Faire Confiance à l'IA

Votre niveau de confiance doit varier en fonction de plusieurs dimensions qui structurent le risque de défaillance.

Par type d’API, les APIs populaires et bien documentées comme requests.get ou S3.get_object offrent une fiabilité élevée (~80%), le modèle les ayant rencontrées des milliers de fois. À l’inverse, les APIs obscures, récentes ou spécialisées affichent une fiabilité très faible (20-30%), nécessitant une vérification systématique de la documentation officielle.

Par domaine de code, le frontend (React, Vue, CSS) est sur-représenté dans les données avec une fiabilité haute. L’infrastructure, CI/CD et le Cloud sont sous-représentés, induisant une fiabilité basse. La cryptographie suscite une méfiance extrême : quasi-absente des données d’entraînement, elle produit du code qui compile mais reste souvent cryptographiquement faible.

Par modèle, GPT-4 affiche la meilleure fiabilité globale grâce à plus de données et de paires (code, test). DeepSeekCoder excelle sur les APIs open-source standards mais hallucine davantage sur les APIs propriétaires. CodeLlama présente généralement une fiabilité inférieure.

Par taille et complexité, les fonctions isolées et simples (moins de 50 lignes, peu de dépendances) offrent une fiabilité raisonnable. Le code repository-level (multi-fichiers, dépendances complexes) multiplie les hallucinations. Les benchmarks synthétiques n’ont pas préparé les modèles à cette complexité contextuelle réelle.

Stratégies de Mitigation : Un Workflow de Validation Multi-Couches

Adoptez une défense en profondeur pour capturer les hallucinations avant la production.

Couche 1 : Alimentez le Contexte (RAG – Retrieval Augmented Generation)

Ne laissez pas le modèle deviner. Fournissez-lui la documentation pertinente, des exemples de code existant dans votre base et la liste des APIs disponibles. Cette approche réduit les hallucinations de 3 à 5%. Attention toutefois à ne retriever que du contexte de haute qualité et pertinent, sous peine de distraire le modèle et de dégrader ses performances.

Couche 2 : Déclenchement Intelligent du RAG (DAG++)

N’utilisez pas RAG à l’aveugle. Déclenchez-le uniquement si l’API que le modèle s’apprête à utiliser est absente de votre index de code, ou si le score de confiance du modèle (la probabilité des tokens générés pour le nom de l’API) est bas, inférieur à 0.3-0.4. Cela évite de dégrader les performances quand le modèle est déjà confiant et correct.

Couche 3 : Tests et Validation Automatisée Renforcés

Les tests unitaires ne suffisent pas. Ajoutez de la static analysis (SonarQube, CodeQL) qui détecte les patterns dangereux, l’absence de gestion d’erreurs et les vulnérabilités de sécurité. Intégrez du linting et du type checking (mypy, eslint) pour attraper les incohérences de types et les erreurs basiques. Les tests d’intégration vérifieront que le code interagit correctement avec les bases de données, APIs externes et autres services. Enfin, la revue de code humaine doit se concentrer sur les zones à haut risque : logique métier, sécurité, cryptographie et utilisation d’APIs peu fréquentes.

Checklist Express pour Auditer du Code Généré

Avant de merger, vérifiez ces points critiques :

- Les imports (import, require) pointent-ils vers des librairies qui existent vraiment ?

- Les noms d’APIs et de méthodes appelées correspondent-ils à la documentation officielle ?

- Le code gère-t-il explicitement les erreurs et les cas limites ?

- Le style et le nommage sont-ils cohérents avec le reste de la codebase ?

- Avez-vous une estimation de la performance, sans boucles infinies potentielles ?

- Le code contient-il des secrets, credentials ou valeurs hardcodées dangereuses ?

Conclusion : Adopter le Bon Mindset pour Coder avec l'IA

La génération de code par IA est un outil puissant, mais son paradoxe fondamental est incontournable : les modèles excellent à produire du code syntaxiquement et statistiquement plausible, mais échouent souvent sur la justesse sémantique et contextuelle.

Changez de mentalité. Le code généré n’est pas une solution clé en main. C’est une excellente amorce, un premier jet qui automatise 80% du travail boilerplate, mais qui nécessite une validation rigoureuse sur les 20% critiques.

Les trois impératifs s’imposent. Faites confiance de manière différentielle : foncez sur le frontend standard et les APIs populaires, mais gardez une méfiance extrême sur le code métier, la sécurité et les APIs obscures. Maximisez le contexte pertinent : nourrissez le modèle avec le code existant, la documentation et les spécifications précises, en éliminant le bruit. Automatisez la vérification : intégrez des outils de static analysis, de linting et des tests d’intégration dans votre CI/CD, laissant la revue humaine se concentrer sur l’exception.

Le paradoxe du code “correct” se résout en comprenant que la correction est multidimensionnelle. L’IA maîtrise la dimension syntaxique et statistique. C’est à vous, développeur, de garantir les dimensions sémantique, logique et contextuelle—structurez vos flux de travail en conséquence, et vous transformerez l’IA en multiplicateur de productivité fiable.

FAQ

Pourquoi le code généré par l'IA compile-t-il tout en étant incorrect ?

Les modèles optimisent pour générer du code syntaxiquement plausible basé sur des patterns statistiques, pas pour une logique ou une vérité sémantique. Ils reproduisent des structures vues durant l’entraînement sans les comprendre.

Quels sont les types d'hallucinations les plus dangereux en génération de code ?

Les hallucinations d’APIs (20.41% des cas) sont les plus critiques car le modèle invente des méthodes qui n’existent pas, conduisant à des plantages en production. Viennent ensuite les violations de requirements fonctionnels (36.66%).

Comment réduire le risque d'hallucinations dans mon flux de travail ?

Combinez RAG (pour fournir du contexte), déclenchez la génération contextuelle uniquement quand la confiance du modèle est basse, et implémentez une validation robuste via static analysis, tests d’intégration et revue ciblée du code à risque.

Sources

- https://arxiv.org/html/2409.20550v2

- https://arxiv.org/html/2407.09726v1

- https://www.infoworld.com/article/3822251/how-to-keep-ai-hallucinations-out-of-your-code.html

- https://openai.com/index/why-language-models-hallucinate/

- https://medium.com/hack-the-stack/the-hidden-memory-patterns-in-transformer-models-that-explain-hallucinations-47cb49fa52f2

- https://arxiv.org/html/2402.00689