Les algorithmes progressent à la vitesse de la lumière, mais les robots restent coincés dans le monde physique. Alors que les LLM se nourrissent de données web gratuites et abondantes, la robotique doit collecter manuellement chaque donnée, seconde après seconde. Un gouffre économique et technique qui définit aujourd’hui les limites de l’IA incarnée.

Un écart abyssal entre données web et données physiques

C’est le paradoxe silencieux de l’IA : plus elle est puissante, plus elle est immatérielle. Là où un modèle de langage comme Llama 2 s’entraîne sur 2 000 milliards de tokens (équivalent à 6 377 années de données en collecte robotique continue), un acteur comme Physical Intelligence a mis un an entier à compiler 10 000 heures de données robotiques pour son modèle PI-0.

La différence ne tient pas seulement au volume. Elle est structurellement insurmontable : les LLM profitent du web scraping, des données gratuites, scalables et automatisées. La robotique, elle, doit envoyer des humains pour collecter des données dans le monde physique, avec ses contraintes impitoyables de gravité, de friction et de casse.

On ne peut pas contourner la physicité. Cette réalité s’impose à toutes les équipes de R&D et explique pourquoi les robots capables d’apprendre de leurs erreurs à grande échelle restent rares. C’est la limite que nul datacenter ne peut franchir.

Les trois piliers qui explosent les coûts de la donnée robotique

La téléopération humaine : le goulot d'étranglement inévitable

La téléopération – piloter un robot à distance via une interface – reste la méthode la plus fiable, mais aussi la plus chère. Historiquement réservée aux experts, elle se démocratise grâce à des interfaces bas coût comme GELLO (~1 000 $), Echo (avec retour haptique simplifié), HACTS (système de copilotage humain) ou U-ARM (interface générale low-cost).

Mais même à bas coût, un opérateur ne produit que 2 à 4 heures de données exploitables par jour. Des projets comme DROID mobilisent 50 opérateurs sur trois continents pour collecter 100+ heures quotidiennes. Une logistique digne d’un studio de cinéma pour capturer ce qui prend quelques secondes aux humains.

Le labelling multimodal : l'invisible qui coûte cher

L’annotation des données robotiques va bien au-delà du simple tagging d’image. Il faut tracer les positions 3D des objets, annoter les états des capteurs et actionneurs, corréler nuages de points et flux vidéo. Une erreur d’annotation peut empoisonner tout un jeu de données et entraîner des comportements dangereux. Résultat : le labelling robotique coûte 40 à 50 $/heure, contre 2 à 5 $ pour l’annotation d’images classiques. Dix fois plus cher pour un travail plus exigeant.

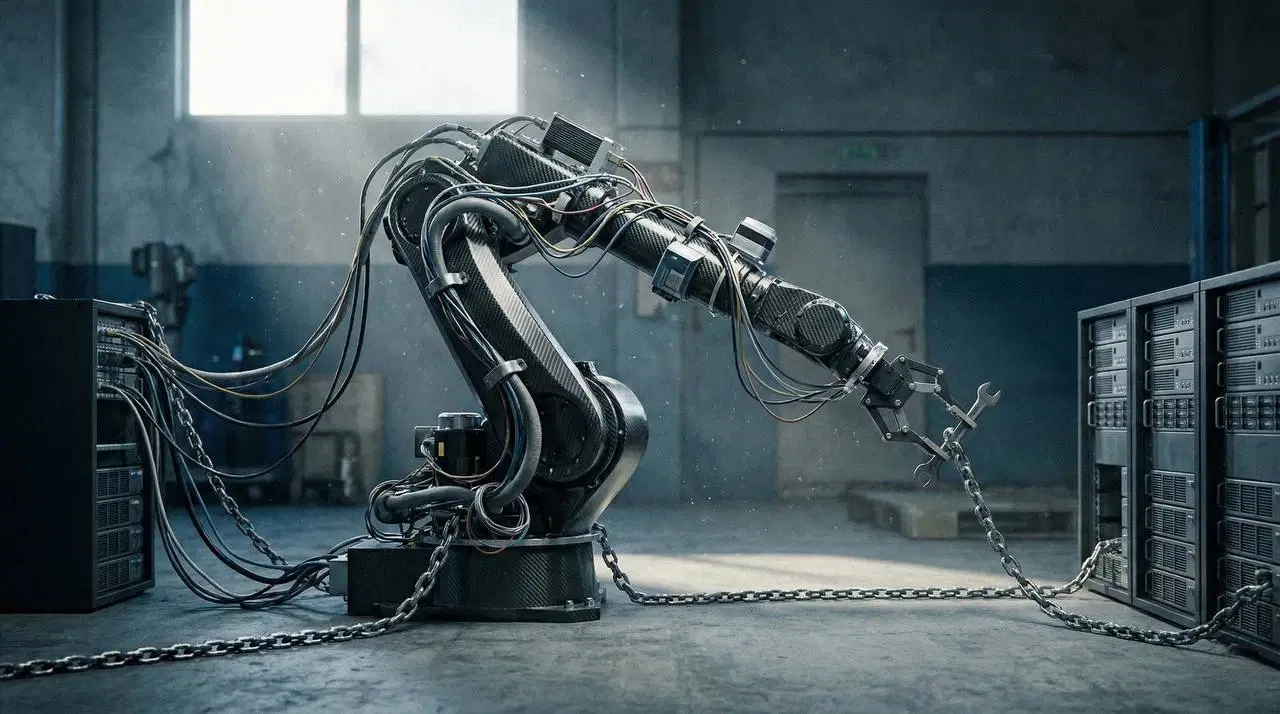

L'usure matérielle : le coût silencieux mais certain

Les robots s’usent, se dérèglent, se cassent. Un bras industriel montre des jeux mécaniques après 10 000 heures. Une main dextère dysfonctionne après 2 000 à 5 000 heures. Le coût annuel de maintenance peut atteindre 500 000 à 2 M$ par robot en utilisation intensive, une contrainte qui pousse à repenser les modèles économiques. Le robot doit générer de la valeur suffisante pour amortir son propre coût de collecte.

Simulation ≠ réalité : le "sim-to-real gap" persiste

L’idée est séduisante : entraîner en simulation (coût nul, temps réel accéléré) puis transposer en réel. Mais la réalité résiste.

La simulation donne de la quantité, pas de la fidélité. Les différences sont fondamentales : frottements parfaits face à la friction réelle, capteurs sans bruit face au bruit de mesure, textures idéales face à la variabilité des matériaux. Des techniques comme le domain randomization (variation délibérée des paramètres) amélioren la robustesse, mais ne remplacent pas les données réelles – surtout celles qui capturent les échecs et les récupérations. Le domaine du “presque cassé” n’existe pas en simulation.

Les trois stratégies de l'industrie pour franchir le mur des données

Face à ce gouffre, trois voies se dessinent, aucune n’étant miraculeuse.

Réduire le coût de la téléopération

L’objectif est clair : démocratiser les interfaces de contrôle pour que chacun puisse contribuer. Des outils comme GELLO ou U-ARM permettent à une startup de collecter 200 h/mois pour environ 30 000 $, contre 200 000 $ il y a dix ans. C’est un progrès réel. Mais l’humain reste incontournable – il faut le payer, le former, gérer sa fatigue. La courbe des coûts s’aplatit.

Données synthétiques et transfert adaptatif

Des projets comme DreamGen ou MimicGen amplifient une démo réelle en la déclinant en variations synthétiques : textures, angles, lumières différentes. Le ratio typique est 1 vers 100, voire 1 vers 1 000 en conditions favorables. Mais cela fonctionne pour les tâches simples (pick-and-place). Dès qu’il s’agit de manipulations complexes, délicates (textiles, liquides, dextérité fine), la synthèse s’effondre. Les pixels synthétiques ne savent pas imiter la souplesse d’un tissu.

Réutiliser les vidéos humaines

Tesla et Humanoid Policy entraînent des robots sur des vidéos filmées du point de vue humain. L’avantage : données réelles, lumière naturelle, bas coût. La limite : le transfert est imparfait quand la morphologie du robot diffère de l’humain (nombre de doigts, amplitudes articulaires). Un humain a deux mains ; un robot à deux bras n’a pas forcément deux mains intelligentes.

L'émergence des plateformes d'infrastructure data

Les gagnants ne seront pas (seulement) ceux qui fabriquent les robots ou les modèles, mais ceux qui organisent la donnée. Des acteurs comme Encord, Labellerr, Cogito, Aya Data ou Deepen AI se positionnent sur l’annotation spécialisée robotique, le versioning et le retrieval de données, la détection d’erreurs et l’assurance qualité.

La donnée brute est cheap ; la donnée organisée est rare. DROID a montré qu’une sélection intelligente des données permettait de surpasser de 70 % les modèles entraînés sur l’intégralité des données brutes. Autrement dit, bien trier 1 000 heures rapporte plus que de balancer 10 000 heures sans discrimination.

DROID : le prototype de la pipeline de demain

Lancé fin 2025, le projet DROID (Deployment Robot Observation Dataset) incarne cette nouvelle approche. 50 collecteurs humains sur 3 continents, robots transportés dans des vans, protocoles de synchronisation stricts. Les modèles entraînés sur DROID avec sélection intelligente affichent des gains de 20 à 50 % sur des tâches jamais vues. C’est la preuve que la logistique de la donnée peut, à elle seule, créer de la valeur.

Questions stratégiques ouvertes

Plusieurs défis restent non résolus et structureront la compétition industrielle.

Y aura-t-il un “CommonCrawl” pour la robotique ? Les LLM ont bénéficié de corpus publics massifs. La robotique n’a pas d’équivalent open et standardisé.

Qui contrôlera la chaîne de valeur ? Les géants (Tesla, Google) internaliseront-ils toute la pipeline, ou un écosystème décentralisé émergera-t-il ?

Qui standardisera les métadonnées ? Il n’existe aujourd’hui aucun format standard pour décrire une action robotique, ce qui oblige chaque acteur à réinventer ses outils.

Conclusion : la physicité comme limite indépassable

La robotique n’est pas qu’un problème de calcul ou d’algorithme. C’est un problème d’économie physique. Les lois d’échelle des LLM ne s’appliquent pas directement. On ne peut pas multiplier les datacenters pour obtenir un robot 10 fois plus performant.

Les gagnants seront ceux qui réduiront le coût de collecte physique, organiseront efficacement le retrieval de données, et standardiseront les formats et métadonnées. Tesla possède un avantage structurel avec ses millions de véhicules collecteurs. Les startups devront inventer des modèles où le robot rentabilise sa propre collecte.

L’enjeu n’est pas dans le modèle. Il est dans l’infrastructure de données – et cette bataille déterminera qui domine la robotique pendant la décennie qui vient.

FAQ

Pourquoi la robotique est-elle à la traîne face aux LLM ?

Par manque de données exploitables à grande échelle et à bas coût.

La simulation peut-elle remplacer les données réelles ?

Non, elle permet un pré-entraînement mais ne comble pas le “reality gap”.

Qui sont les acteurs clés de l'infrastructure de données robotiques ?

Les plateformes de data ops comme Encord, Labellerr ou Cogito.

Sources

- https://www.ibm.com/think/news/the-data-gap-holding-back-robotics

- https://itcanthink.substack.com/p/how-can-we-get-enough-data-to-train

- https://arxiv.org/html/2506.13536v1

- https://arxiv.org/html/2509.02437v2

- https://slow-thoughts.com/the-sim-to-real-gap/

- https://www.cvat.ai/resources/blog/robotics-data-annotation

- https://arxiv.org/html/2503.24070v1