Claude Opus 4.5 : la productivité IA au prix du burnout0

- Codage

- 11 Feb à 09:59

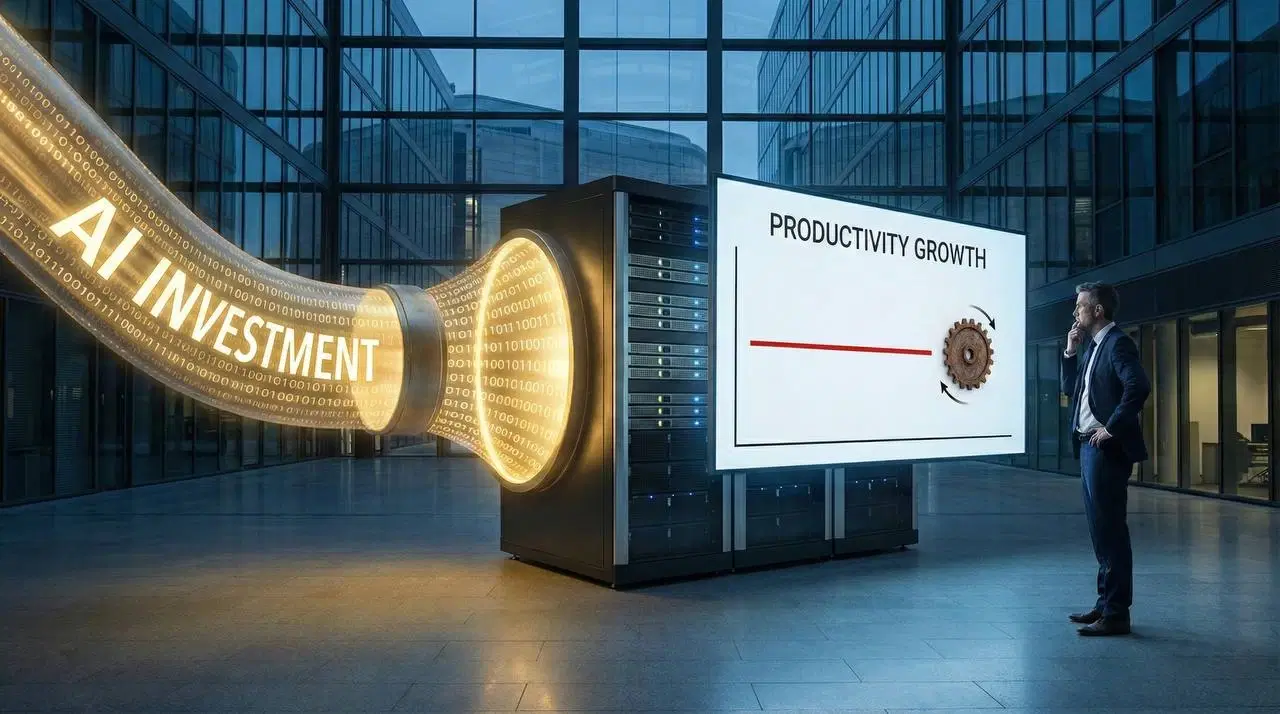

Claude Opus 4.5, lancé par Anthropic le 24 novembre 2025, franchit un seuil rarement atteint en intelligence artificielle. Le modèle obtient 80,9 % au benchmark SWE-Bench Verified, première fois qu'un modèle d'IA dépasse la barre des 80 %. Microsoft teste massivement Claude Code en interne depuis janvier 2026, mais Steve Yegge alerte : cette productivité 10x profite uniquement aux employeurs, laissant les développeurs épuisés.

LIRE LA SUITE